개요

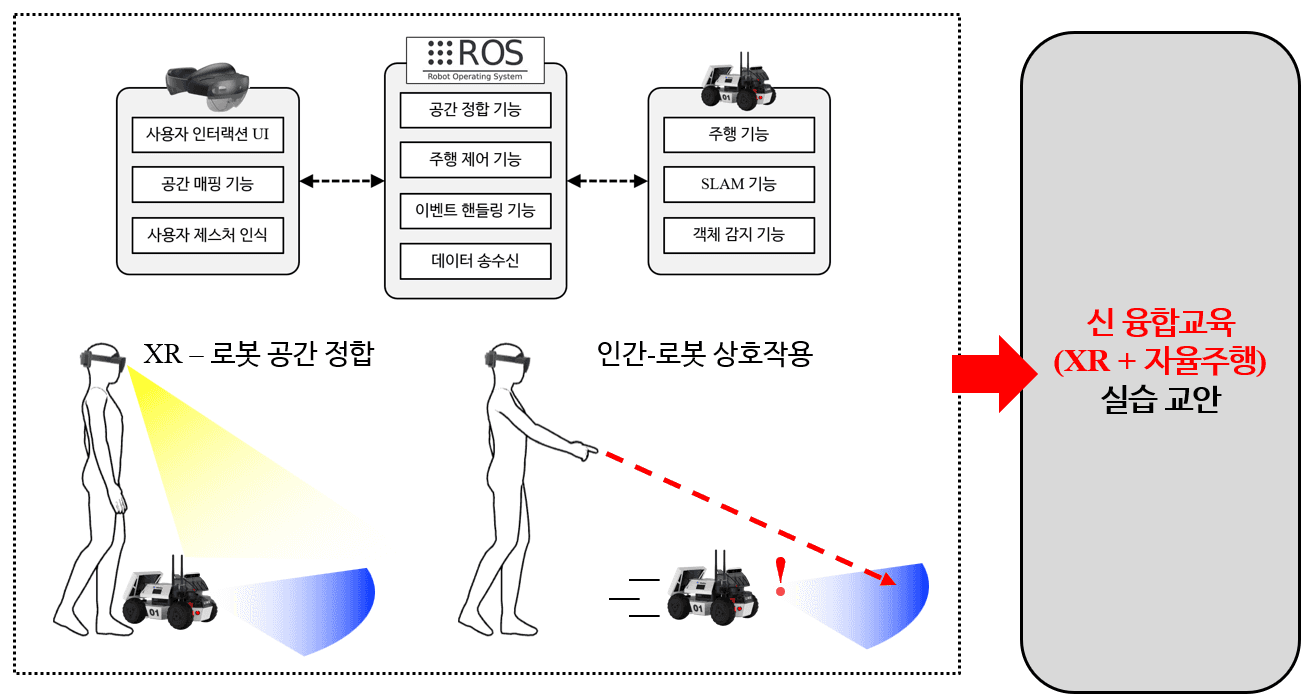

본 연구는 XR(확장현실) 기술과 자율주행 로봇 기술을 융합하여, 학습자가 몰입형 환경에서 로봇 제어 및 자율주행 원리를 학습할 수 있는 XR 기반 자율주행 실습 교안을 개발하는 연구로,

HoloLens 2와 ROS 기반 Limo Pro 로봇 간 통신 및 공간 정합 기술을 구현하여, XR 환경에서 실제 로봇의 상태와 위치를 실시간으로 시각화함

또한 XR UI 및 핸드 제스처, 포인팅 기반 인터랙션을 통해 로봇 제어와 SLAM, 객체 감지 등의 실습을 포함함

본 포트폴리오는 교안의 내용보다는 교안 개발을 위해 개발된 XR–로봇 융합 교육 시스템의 구현 결과에 초점을 두어 기술함

연구 목적 & 필요성

로봇의 자율주행 기술은 인공지능, 센서 융합, 공간 인식 등 복합적 기술 발전에 따라 스마트 모빌리티와 서비스 로봇 등 다양한 분야의 핵심 기술로 대두되고 있으며, 이에 대한 교육적 수요 또한 급격히 증가하고 있음

동시에 XR(확장현실) 기술은 실감형 인터페이스와 몰입형 학습 환경을 제공하는 차세대 교육 기술로 주목받고 있으며, 산업 전반에서 그 활용 가치가 높아지고 있음

그러나 기존의 교육은 로봇 제어나 자율주행, XR 기술 중 개별 기술에 국한된 실습 중심 교육에 집중되어 있으며, 두 기술을 융합하여 학습자가 자율주행 로봇을 XR 환경에서 직접 제어하고 상호작용할 수 있는 통합 교육은 거의 전무한 실정임

이에 본 연구는 XR과 자율주행 로봇 기술을 융합한 상호작용 중심의 실습 교안을 개발하여, 학습자가 실시간 공간 정합 및 인간-로봇 상호작용(HRI)을 통해 XR 기술과 로봇 기술을 활용하는 방법을 직관적으로 이해하고 실습중심으로 학습할 수 있는 교육 환경을 구축하고자 함

연구 내용

본 연구는 교내 보유 중인 HoloLens 2 및 LIMO Pro 로봇 장비를 활용하여 XR–로봇 융합 교육을 위한 실습 교안 개발을 수행함

XR 환경은 UWP(Universal Windows Platform) 기반의 Unity 엔진을 통해 구현되었으며, 로봇은 Ubuntu 18.04 기반 ROS1 Melodic을 통해 개발함

교안 개발을 위해 포함된(구현된) XR–로봇 융합 교육 시스템은 크게 1) 객체 감지 기능, 2) 네비게이션 기능, 3) 사용자 제스처 및 버튼 UI 기반 주행 제어 기능, 4) 사용자 포인팅 기반 주행 제어 기능으로 구성됨

이를 통해 XR 공간 내에서 사용자의 제스처 및 UI 입력에 따라 로봇이 실시간으로 반응·주행하는 인터랙션 교육 환경을 구현

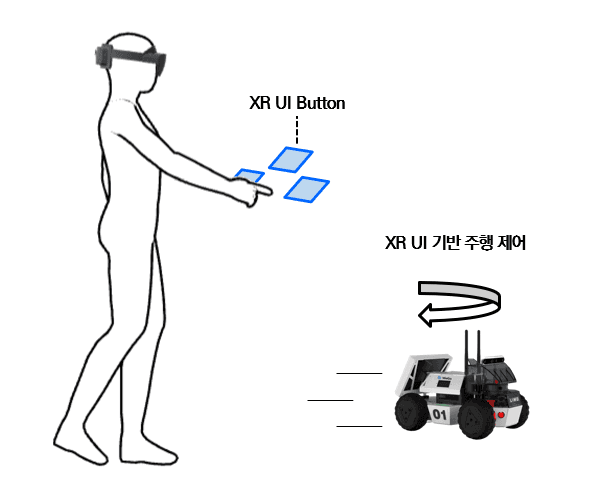

XR UI 기반 로봇 주행 제어

본 기능은 HoloLens 2 기반 XR 환경에서 사용자의 버튼 입력을 TCP 통신을 통해 ROS 시스템으로 전달하여,

LIMO Pro 로봇의 전진·후진·회전 등 기본 주행 동작을 실시간으로 제어하는 인터랙션 기능

HoloLens 2(UWP + Unity) 환경에서 구현된 버튼 UI를 통해 사용자는 XR 공간 내에서 직관적으로 로봇을 제어할 수 있으며,

입력된 제어 신호(Flag 값)는 TCP 프로토콜을 통해 ROS 환경으로 전송됨

ROS 환경에서는 수신된 Flag 값을 기반으로 토픽을 발행하여 선속도(linear velocity)와 각속도(angular velocity)를 제어함

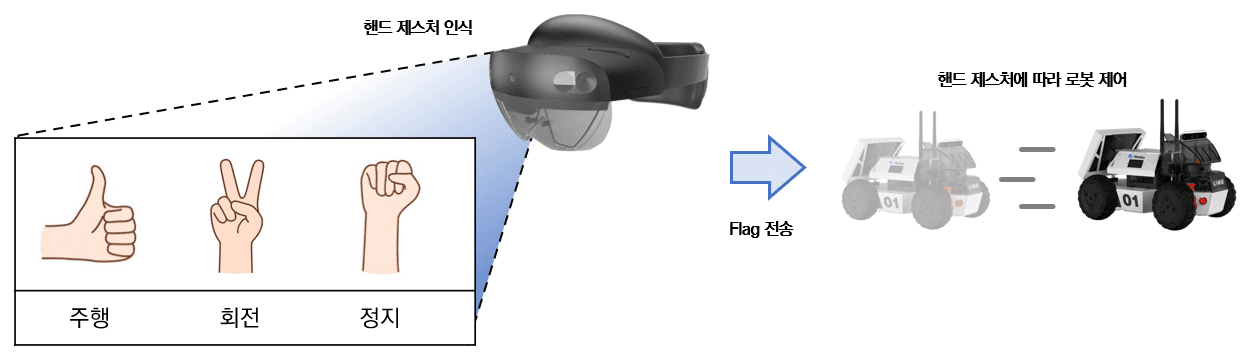

제스처 기반 로봇 주행 제어

본 기능은 HoloLens 2 기반 XR 환경에서 사용자의 제스처 인식을 통해 로봇 주행을 제어하는 인터랙션 기능

HoloLens 2(UWP + Unity) 환경에서 구현된 Hand Tracking을 활용하여,

사용자의 Fist, V, Thumbs up 핸드 제스처를 인식함

Fist: 정지

V: 회전

Thumbs up: 주행

인식된 제스처를 제어 신호(Flag 값)로 변환하여 TCP 통신을 통해 ROS 환경으로 전송되며,

ROS 환경에서는 수신된 Flag 값에 따라 토픽을 발행하여 로봇의 선속도(linear velocity)와 각속도(angular velocity)를 제어함

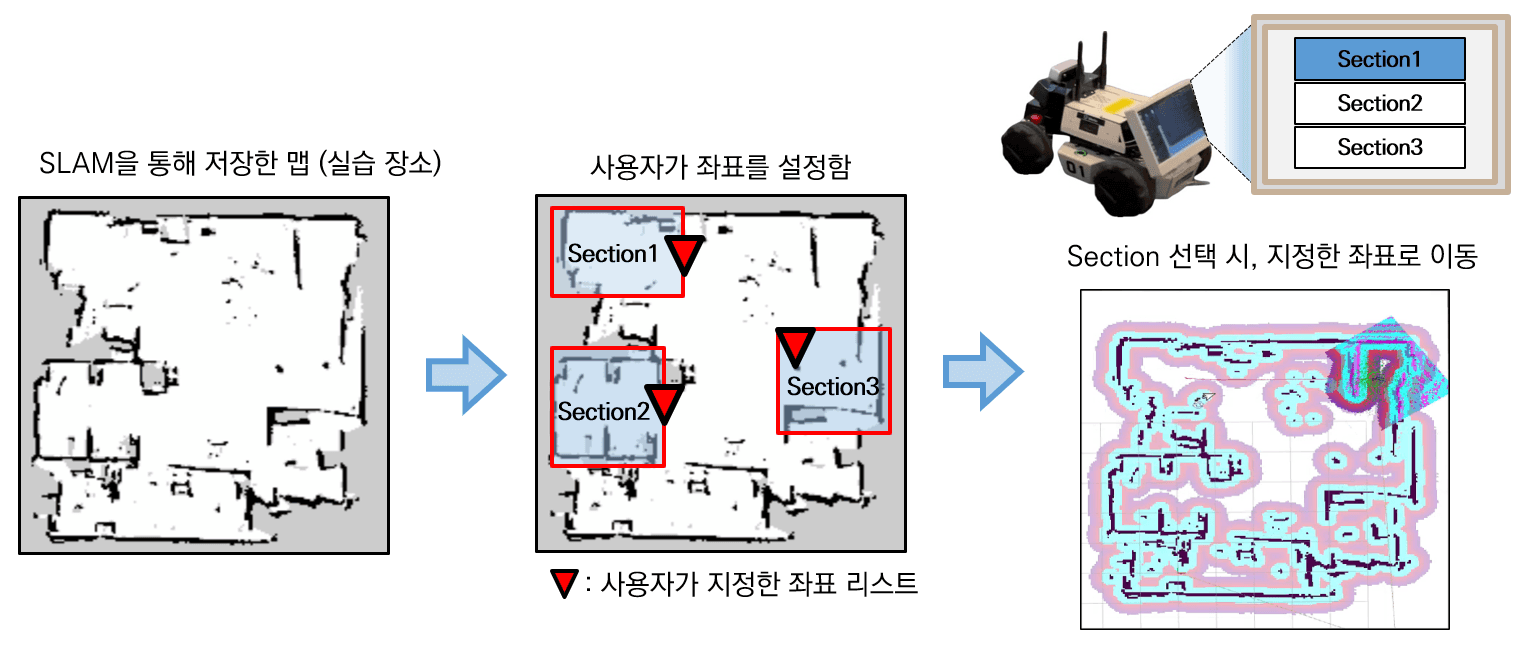

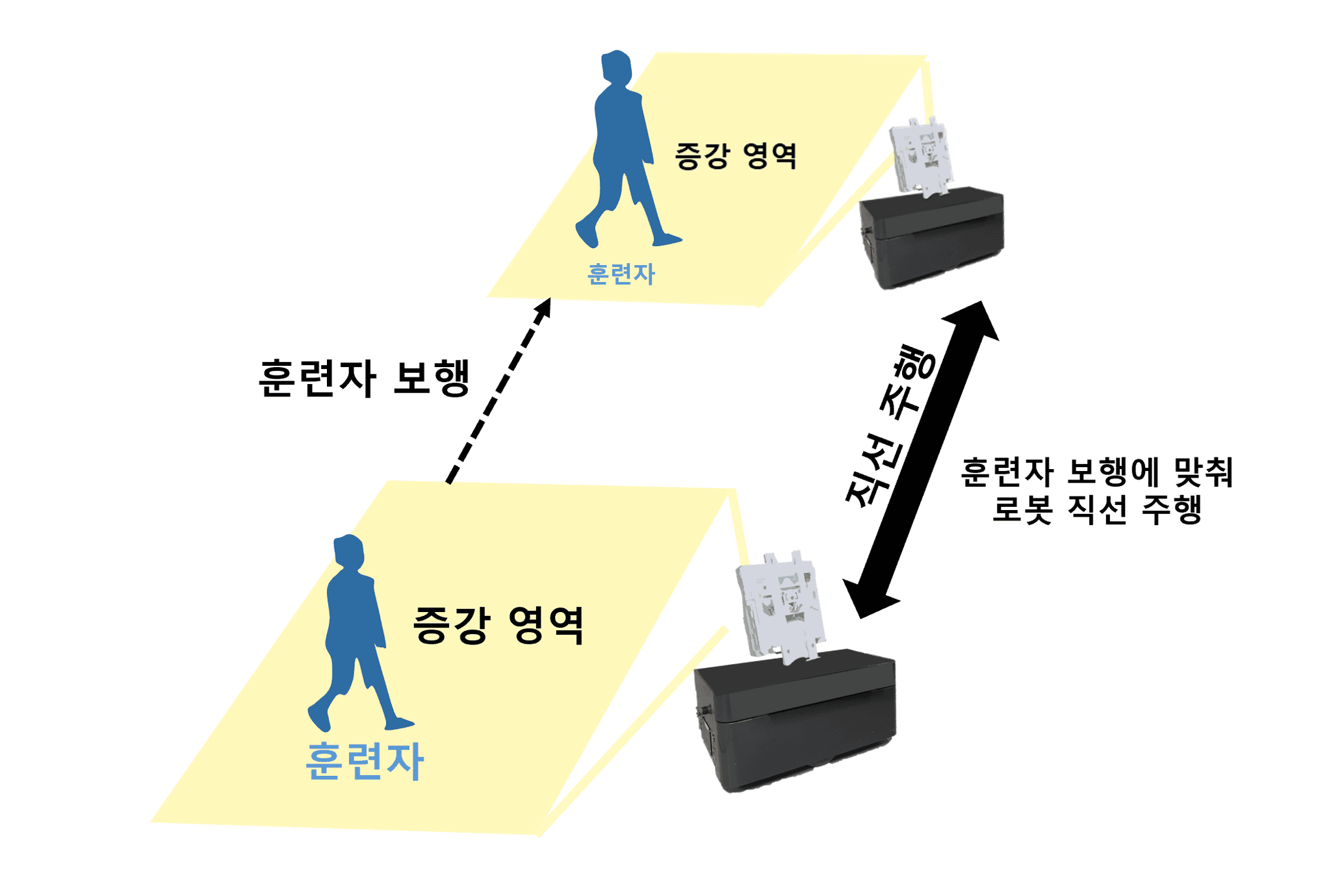

로봇 안내 기능

본 기능은 HoloLens 2 기반 XR 환경에서 사용자가 설정한 다중 목적지 정보를 바탕으로 로봇이 지정된 위치까지 자율주행하도록 하는 안내(Navigation) 기능

초기 사용자는 XR 환경에서 여러 개의 목적지 좌표를 설정하면, 로봇은 이를 내부 데이터베이스에 저장함

이후 다른 사용자가 XR 인터페이스 내 UI 버튼을 통해 원하는 목적지를 선택하면,

해당 정보가 TCP 통신을 통해 ROS 환경으로 전송되고,

ROS 환경에서는 SLAM 맵 내 최적 경로를 탐색·생성하고 장애물을 피해가며 로봇이 선택된 목적지까지 안내함

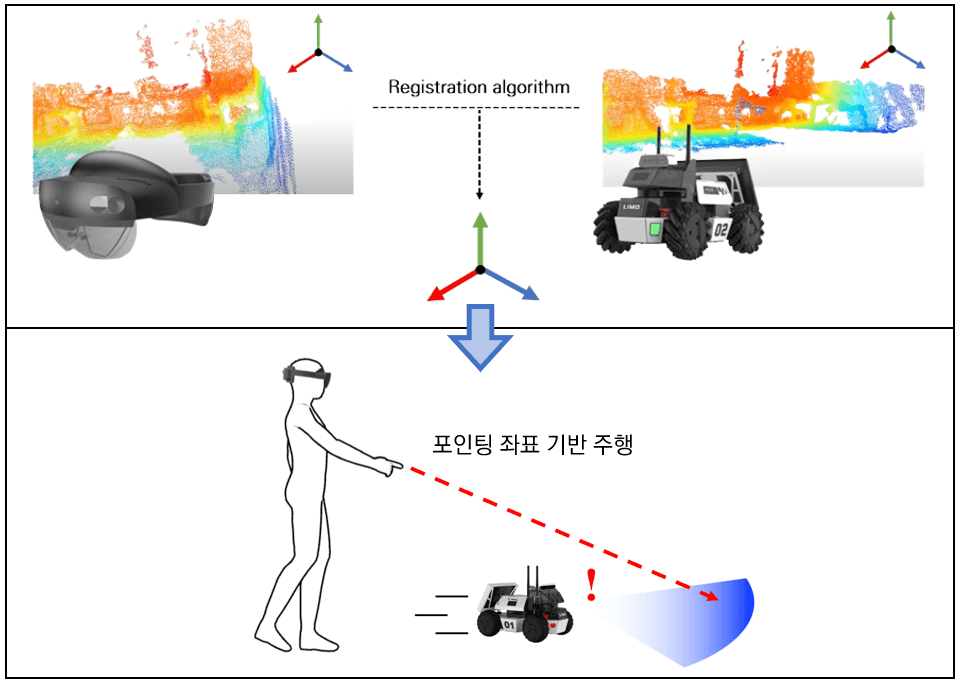

XR-로봇 공간정합 및 포인팅 기반 로봇 주행 제어

본 기능은 HoloLens 2의 포인팅(Pointing) 제스처를 통해 지정된 위치로 로봇을 이동시키는 공간정합(Spatial Registration) 기반 로봇 주행 제어 기능

HoloLens–Server–로봇 간 다중 좌표계 정합 구조로 구성됨

HoloLens에서는 사전에 3D Point Cloud 형태의 공간 맵을 생성 및 저장하고, 로봇 측에서도 2D Lidar 기반 Point Cloud map을 생성 및 저장함

Server는 두 맵을 ICP 알고리즘(Iterative Closest Point)으로 정합(Registration)하여 하나의 통합 글로벌 좌표계를 구성하며,

이 글로벌 좌표계 내에서 HoloLens, 로봇, 포인팅 좌표의 상대적 위치를 하나의 공간 내에서 실시간으로 관리·갱신함

HoloLens는 자신의 위치 좌표를 Server로 주기적으로 전송하며, Server는 이를 글로벌 좌표계 기준으로 변환함 (변환행렬을 통해)

(본 ICP에서는 로봇의 Point Cloud map에 홀로렌즈 Point Cloud map을 정합하였음, 따라서 로봇의 map(좌표계)을 글로벌 좌표계로 정의)

사용자가 XR 환경에서 포인팅 제스처로 바닥을 지정하면, HoloLens는 해당 지점의 Local 좌표를 Server로 송신하고,

Server는 이를 글로벌 좌표로 변환 (변환행렬을 통해)한 뒤 ROS 시스템에 전달함

ROS 측에서는 수신된 좌표를 기반으로 Path Planning을 수행하고, 로봇은 해당 지점으로 이동을 수행함

추가적으로, Server(PC)에서는 세 좌표 (Hololens, Robot, Pointing position)을 실시간으로 시각화하여 하나의 공간내에서 위치를 확인할 수 있도록 시각화 프로그램을 개발함

역할

본 프로젝트에서는 박사 과정 연구원으로서 XR–로봇 융합 교육 시스템의 설계·개발, 및 교안 개발 전반을 주도하였다. HoloLens 2와 LIMO Pro 로봇 간 통신 구조(UWP–ROS) 설계, 버튼·제스처·포인팅 기반 로봇 제어 기능 개발, 및 ICP 기반 공간정합 알고리즘 구현을 직접 수행하였으며, Server–HoloLens–로봇 간 좌표 변환 및 데이터 통신 시스템을 구축하여 XR-로봇 융합 기술을 개발하였다. 또한 개발된 시스템을 교육에 적용하기 위한 ROS 제어·SLAM·객체 감지·제스처 제어 등 실습 교안을 직접 설계 및 제작하였다. 이를 통해 XR과 로봇 시스템의 통합 개발 전 과정을 수행할 수 있는 실무 역량을 강화하였으며, 실시간 통신 구조 설계, 공간정합 알고리즘, UWP(Unity)·ROS 개발 역량 및 교육 콘텐츠 개발 프로세스에 대한 깊이 있는 이해를 확보할 수 있었다.

본 연구는 한국기술교육대학교 미래교육혁신처의 "XR을 이용한 상호작용 중심의 자율주행 기술 교안 개발" 연구 과제로 수행되었습니다.