개요

본 연구는 VR HMD를 통해 OTT(Over-The-Top) 콘텐츠를 시청 시 발생하는 시각적 멀미(VR Sickness, Cyber Sickness) 를 저감하기 위한 실시간 영상 중계 및 보정 방법에 관한 연구로,

이를 위해 VR HMD(Vive Pro Eye) 를 통해 사용자의 안구운동 및 머리 움직임 데이터를 수집하고, 동시에 콘텐츠 영상의 Optical Flow 및 Depth Map 정보를 분석하여 사용자 멀미 수준을 실시간으로 예측함

예측된 멀미 수준에 따라 콘텐츠 내 특정 영역에 동적 블러링(Blurring) 효과를 적용하여, 사용자 몰입감은 유지하면서 멀미 유발 요인을 감소시키는 시스템을 개발함

최종적으로 본 시스템은 OTT 스트리밍 환경에서도 실시간 적용 가능한 멀미 저감 서비스로, 관련 특허 2건이 출원됨

연구 목적 & 필요성

최근 OTT 서비스는 영화, 드라마뿐만 아니라 HMD 기반의 3D·VR 콘텐츠로 확장되고 있으며, 향후 몰입형 콘텐츠의 핵심 플랫폼이 될 것으로 전망됨

그러나 VR 멀미(VR Sickness)는 이러한 HMD 기반 콘텐츠의 대중화를 저해하는 주요 요인으로, 사용자 체험 품질(QoE) 향상을 위해 필수적으로 해결되어야 함

기존 멀미 저감 연구는 대부분 개별 VR 콘텐츠 개발 단계에서 적용되었으며, 이미 상용화된 콘텐츠에 실시간으로 적용 가능한 연구는 거의 전무함

또한 하드웨어 중심의 접근은 디바이스별 성능 차이로 인해 일반화가 어렵기에, 소프트웨어 기반의 실시간 멀미 저감 시스템이 필요함

이에 본 연구는 OTT 플랫폼 상에서 별도의 콘텐츠 수정 없이 실시간으로 멀미 저감 효과를 제공할 수 있는 실용적 기술을 개발하는 것을 목표로 함

시스템 개요

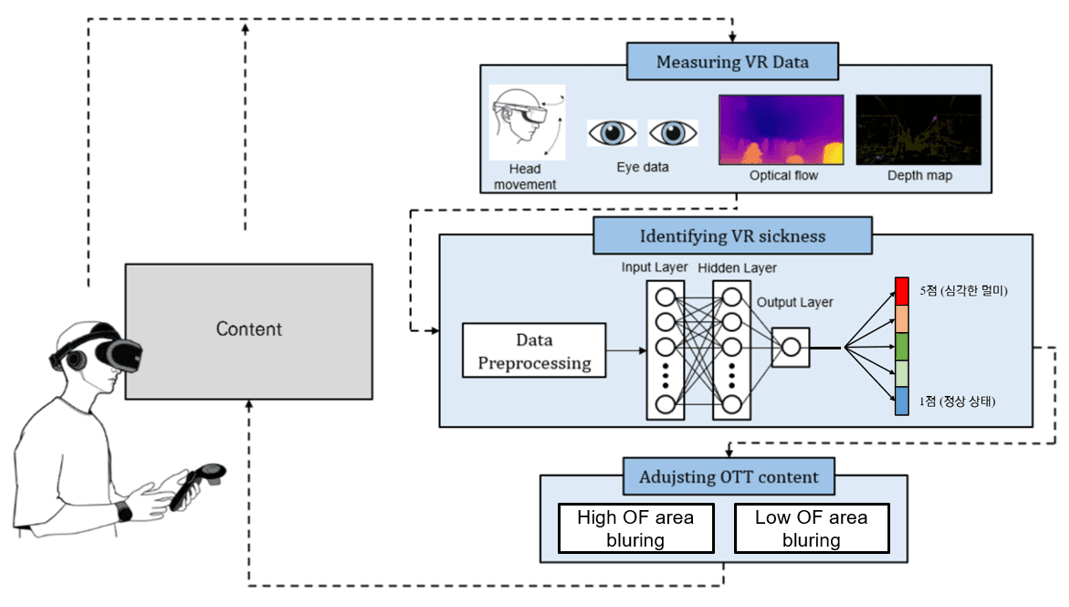

본 시스템은 크게 “Measuring–Identifying–Adjusting”으로 구성됨

Measuring VR Data (데이터 측정 단계)

HMD(Vive Pro Eye)를 통해 사용자의 시선 추적(안구운동) 및 머리 움직임 데이터를 실시간 수집

시청 중인 콘텐츠로부터 Optical Flow 및 Depth Map을 추출하여 시각적 요인을 정량화

Identifying VR Sickness (멀미 판별 단계)

수집된 사용자·콘텐츠 데이터를 기반으로 한 딥러닝 분류 모델을 통해 사용자 멀미 수준(FMS score)을 예측

모델은 기존 석사논문 기반 회귀모델을 OTT 환경에 맞게 경량화 및 분류모델로 재학습하여 사용

Adjusting OTT Content (콘텐츠 조정 단계)

Optical Flow 분석 결과에 따라 Optical Flow가 높거나 낮은 영역에 블러링 효과(𝑀𝐿, 𝑀𝐻) 를 적용

사용자 멀미 수준이 높을수록 블러링 영역을 동적으로 확장하여 Optical Flow를 완화

Measuring VR Data

OTT 콘텐츠 시청 중 사용자의 생리적 반응과 시각적 콘텐츠 특성을 병렬적으로 측정하여, 멀미 예측 모델의 입력 데이터로 활용하기 위한 모듈

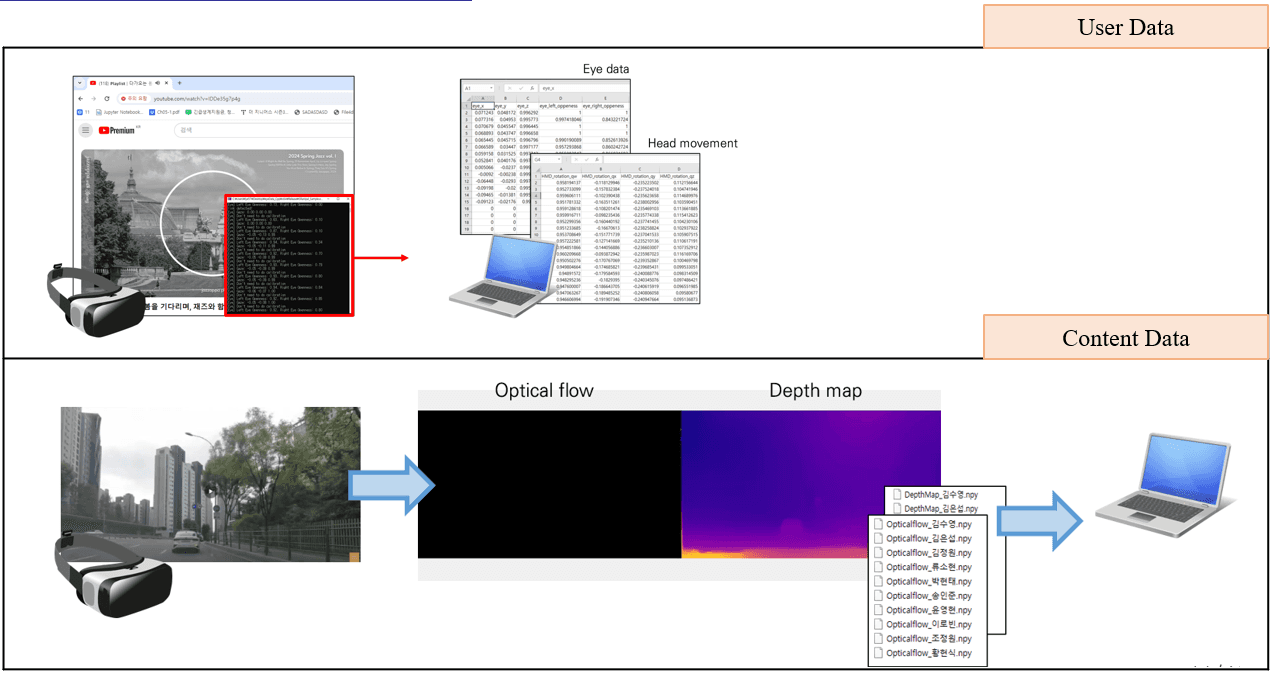

측정되는 데이터는 크게 1) 사용자 데이터(User Data), 2) 콘텐츠 데이터(Content Data)로 분류됨

사용자 데이터

- HTC Vive Pro Eye를 통해 안구운동(동공 크기, 시선, 눈 개방 정도)과 머리 움직임(Position, Rotation)을 실시간 측정함

- 측정된 데이터는 시계열(Time-Series) 데이터로 서버(PC)에 전송되어 .csv 형태로 저장됨콘텐츠 데이터

- 사용자가 시청하는 콘텐츠로부터 Optical Flow와 Depth Map을 실시간 추출함

- Optical Flow와 Depth Map은 3fps로 저장, 전송 효율을 위해 100×100 크기 리사이즈, 1채널 변환, .npy 포맷으로 변환 후 서버로 전송됨

- Depth Map은 단일 영상으로부터 MiDaS 딥러닝 모델을 통해 추정되며, Optical Flow는 Python+OpenCV을 통해 추출함

사용자-콘텐츠 데이터 간 동기화 데이터셋을 실시간 구축하여, 이후 VR 멀미 예측을 위해 사용됨

Identifying VR sickness

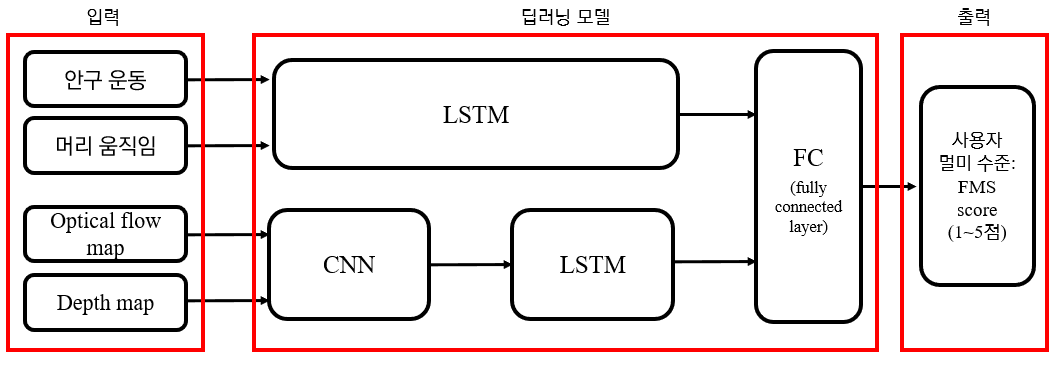

측정된 사용자·콘텐츠 데이터를 기반으로 사용자의 VR 멀미 수준(FMS score)을 분류하는 모듈로, OTT 실시간 환경에 맞게 경량화된 딥러닝 모델을 설계함

입력 데이터: 사용자 데이터(안구·머리 움직임) + 콘텐츠 데이터(Optical Flow, Depth Map)로 구성되며, 전처리 과정을 통해 결측값 보정(Linear interpolation), 정규화(Min–Max), 패딩 및 Flattening을 수행함

딥러닝 구조: 사용자 데이터는 LSTM 네트워크, 콘텐츠 데이터는 CNN-LSTM 네트워크로 처리하여 각각의 시계열·공간적 특징을 추출함

두 네트워크의 출력(Feature)을 Fully Connected Layer에서 병합하여 최종적으로 1~5단계의 멀미 수준(FMS Class)을 분류함(출력)

LSTM 입력은 22차원(Head:6, Eye:16) 벡터이며, CNN-LSTM 입력은 1×100×100 크기(채널×높이×너비)의 Optical Flow/Depth Map 영상 시퀀스

하이퍼파라미터 최적화: Hidden size(64,128,256)와 Layer 수(2,4,6)에 대해 Grid Search를 수행하여, 최적 조합을 도출함

이를 통해 실시간 스트리밍 환경에서도 동작 가능한 경량화 모델을 구현함

Adjusting OTT content

딥러닝 모델로 예측된 멀미 수준(FMS score) 에 따라 OTT 콘텐츠 내 시각적 자극을 실시간으로 조정하여, 사용자의 멀미를 효과적으로 저감하는 동적 블러링 제어 모듈

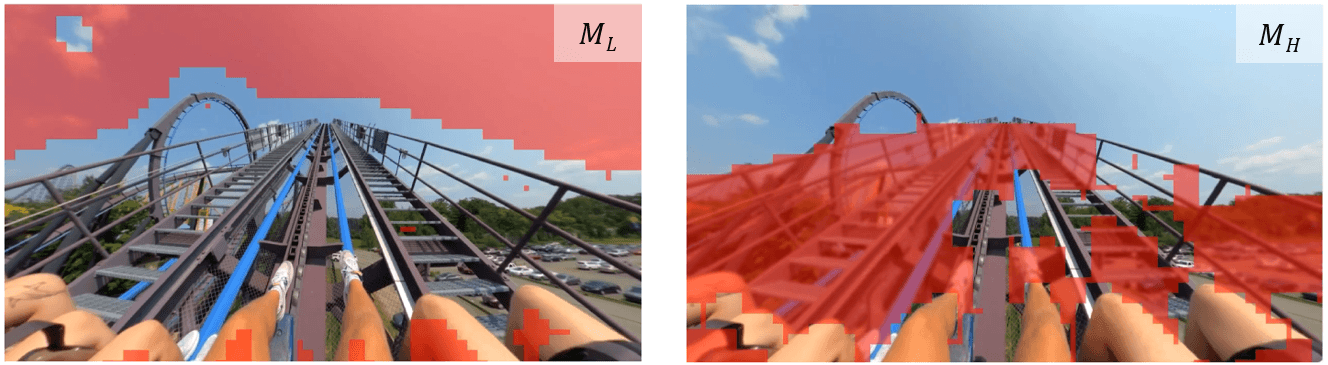

제안된 방법은 두 가지 방식으로 구성됨

1) ML 방식: Optical Flow가 낮은 영역에 Blur 효과를 적용

2) MH 방식: Optical Flow가 높은 영역에 Blur 효과를 적용콘텐츠 내 Optical Flow는 프레임 간 픽셀 단위 이동량을 계산한 후 블록 단위로 평균화를 수행하고, 이후 0~1 범위로 정규화(Normalization)하여 블러링 적용 기준값으로 활용함

해당 모듈은 웹 확장 프로그램(Web Extension) 기반 구조로 구현되어, OTT 스트리밍 콘텐츠(ex. Youtube, Netflix) 위에 실시간 블러링 효과를 오버레이 형태로 적용할 수 있도록 개발됨

예측된 사용자 멀미 수준(FMS score)에 따라 블러링 적용 영역이 동적으로 조절되도록 구현됨 (멀미 수준이 높을수록 블러링 영역 확대)

파일럿 테스트 결과, ML·MH 두 방식 모두 원본 콘텐츠 대비 SSQ 점수가 유의하게 감소(p<0.05) 하였고, IEQ(몰입도) 점수에서는 유의한 차이가 나타나지 않아 몰입감을 유지하면서 멀미를 완화함을 확인함

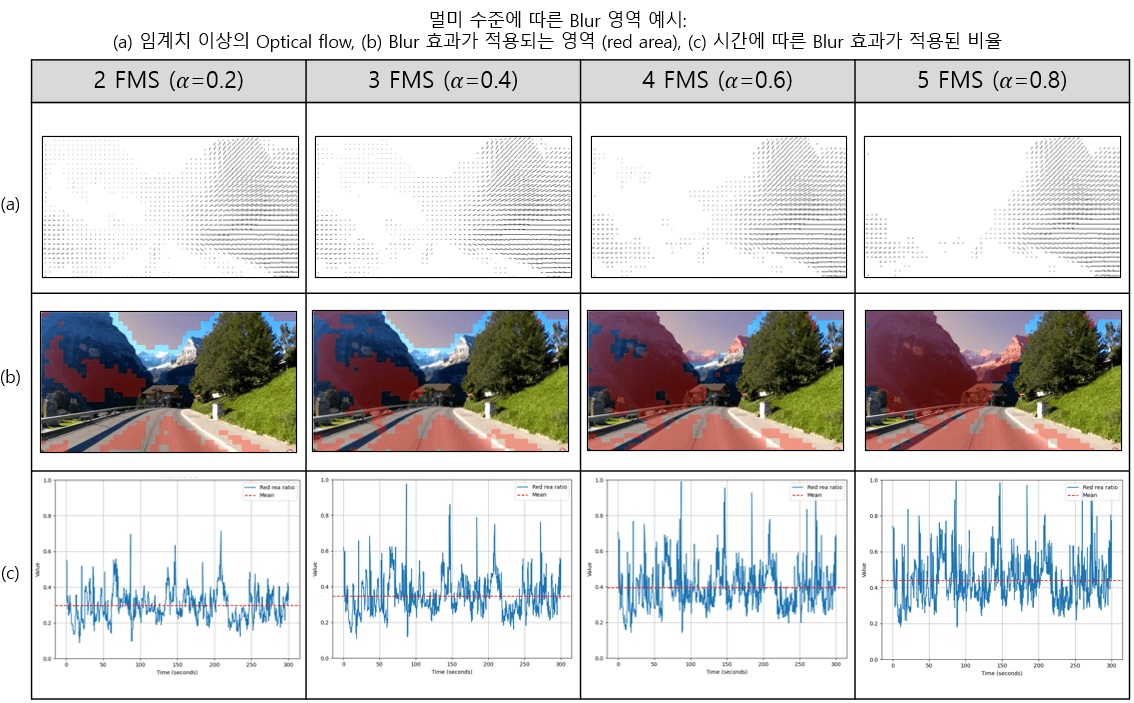

Adaptive Blur Scaling

딥러닝 모델이 예측한 FMS 값(1~5점: 사용자 멀미 수준)에 따라 임계 파라미터 α(0.2~0.8)를 자동 조정하고, Optical Flow–Blur 결합 알고리즘에 반영함

α 값이 증가할수록 Blur 적용 영역(None-Optical Flow Region)이 확장되어, 멀미 수준이 높을수록 시각적 자극(시각적 복잡도)을 더 강하게 완화함

멀미 수준이 증가할수록 Blur 효과가 적용되는 영역의 평균 비율이 약 5%씩 증가

FMS(α=0.2) 시 Blur 영역 29%, FMS5(α=0.8) 시 Blur 영역 44%

이를 통해 사용자의 멀미 수준에 적응적으로 반응하는 지능형 Adaptive Blur Scaling 시스템을 구현함